L’intelligenza artificiale non è così avanzata come potrebbe pensare

Inizia con i sistemi da cui è stato costruito

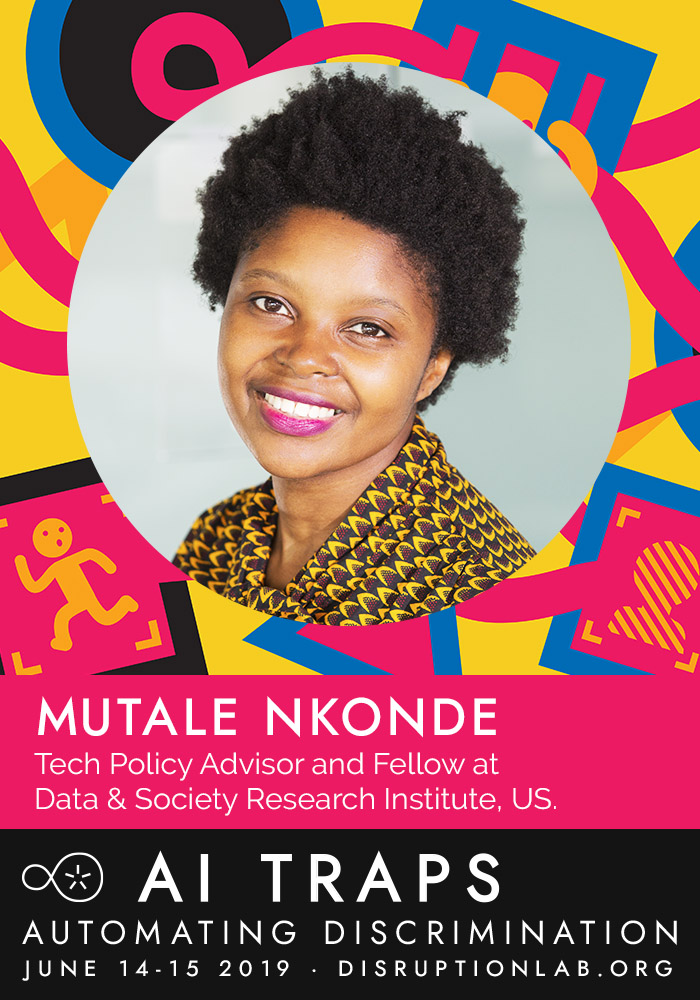

Di Mutale Nkonde

Mi chiamo Mutale e sono un esperto di Governance dell’Intelligenza Artificiale (AI). Questa è la mia area di competenza, ma ogni volta che lo dico, mi sembra strano. Questo principalmente perché sono una delle poche donne nere in questo spazio. E anche se preferirei lavorare dietro le quinte, continuo a camminare in troppe stanze dove le persone non credono che le macchine possano essere razziste per me stare in disparte. Queste interazioni possono essere davvero difficili e ancora non so come gestire il disagio. Ma qual è l’alternativa?

L’intelligenza artificiale sta cambiando tutto da come siamo selezionati per i posti di lavoro a prescindere dal fatto che ci vengano concessi prestiti bancari. Un recente rapporto di McKinsey ha scoperto che le tecnologie di IA hanno il potenziale per aggiungere da qualche parte tra $ 3,5 e $ 5,8 trilioni all’economia degli Stati Uniti, attraverso 19 settori, attraverso la raccolta e la monetizzazione dei nostri dati. Questo è incredibilmente eccitante ma mi preoccupa anche. I sistemi di intelligenza artificiale non possono leggere il contesto sociale, eppure sono stati sviluppati per soddisfare i bisogni di tutta l’umanità.

La mia domanda: chi c’è dietro le quinte crea questa ricchezza? Un rapido sguardo al sito web di ricerca di Google AI fornisce alcune informazioni: elenca 893 persone che lavorano su “machine intelligence”. Solo una è una donna di colore – sì, ho detto una – il numero prima delle due e dopo zero.

Lo stesso vale per Facebook, che elenca 146 persone nel suo team di ricerca AI, ma nessuno è nero – non uno. Tutto ha senso quando ti rendi conto di quante donne di colore stanno ottenendo un dottorato in Informatica. Uno studio condotto dalla Computing Research Association ha rilevato che quattro donne di colore si sono laureate con un dottorato in Informatica nel 2014 . Il futuro è qui ed è piuttosto vaniglia.

La mia carriera è stata lanciata attraverso la Fellowship di Data & Society e supportata dalle brave persone di AI Ethics Twitter. Essendo uno dei primi mezzi il mio lavoro è stato caratterizzato pesantemente dalla stampa. Ho parlato nelle università di tutti gli Stati Uniti e andrò in Germania per tenere una nota chiave il prossimo mese. Tuttavia, non posso e non voglio essere l’unica.

L’intelligenza artificiale è qui e può essere razzista

Per comprendere le implicazioni delle donne di colore che vengono lasciate fuori da questo campo, dobbiamo esaminare il contesto sociale in cui è costruita la tecnologia AI. Brandies Marshall, professore di informatica presso lo Spelman College, afferma che gli algoritmi sono il “cervello” di tutti i sistemi tecnologici. Per prendere queste decisioni, i ricercatori di IA addestrano gli algoritmi attraverso un processo comunemente noto come machine learning (ML).

ML è un ramo dell’intelligenza artificiale, un sottocampo dell’informatica. ML funziona identificando i modelli in grandi quantità di dati sulla popolazione (o “big data”), creando associazioni e li usa per prevedere il comportamento futuro. Queste previsioni sono convertite in modelli statistici, che sono usati per prendere decisioni sulla nostra vita quotidiana.

Ad esempio, le forze di polizia possono utilizzare i dati storici di arresto per creare un modello statistico per identificare “punti caldi della criminalità”. Tuttavia, se le fermate si verificano attraverso pratiche come stop e frisk in cui il 90% degli uomini di colore presi di mira erano innocenti, il set di dati non è in realtà un record di crimine, ma piuttosto un esempio di polizia che blocca innocenti uomini neri e marroni. Le forze di polizia ricevono questi dati e inviano un gran numero di agenti di polizia in queste comunità. I dati vengono utilizzati in modo improprio per prevedere il comportamento criminale.

Come sottolinea il matematico Cathy O’Neil, qui si presuppone che il processo decisionale algoritmico sia oggettivo, quando in realtà codifica effettivamente i pregiudizi dei suoi sviluppatori in modelli statistici – ciò che lei chiama armi di distruzione matematica, a causa dell’impatto della polarizzazione algoritmica ha sulla vita delle comunità minoritarie.

Quel che è peggio, il sociologo Eduardo Bonilla-Silva ha recentemente scoperto un fenomeno chiamato razzismo daltonico , caratterizzato da persone che insistono nel non vedere il colore, ma allo stesso tempo non fanno nulla per smantellare i sistemi razzisti. Lascerò che affondino.

Ho appena pubblicato un rapporto in cui gli scienziati informatici si descrivono tipicamente come daltonici. Essi non hanno la literacy razziale per identificare e rimuovere i proxy razziali, come i dati di arresto e di formazione Frisk durante la fase di progettazione algoritmica! Quindi siamo qui con una serie di sistemi di IA razzisti usati per decidere tutto da quando le nostre macchine si fermeranno, a quali tipi di persone viene offerta assistenza sanitaria.

Aspettare. Non ho finito tutto. Gli algoritmi sono considerati la “salsa segreta” che guida le tecnologie IA. Questi sono protetti dalle leggi sulla proprietà intellettuale, il che significa che non possiamo ritenere queste aziende responsabili della discriminazione razziale perché non sappiamo come fanno le loro decisioni!

È qui che vengo. Mi vedo come discendente di Ida B. Wells, il famoso giornalista / attivista anti-linciaggio. Tuttavia, sto usando le prove del bias di IA per introdurre una legislazione che protegga i diritti civili digitali degli afroamericani.

Il mio lavoro è alle prese con il modo di sviluppare nuovi quadri legali per rendere le aziende tecnologiche responsabili. Attualmente, possiamo solo perseguire per atti di discriminazione intenzionali, ma come possiamo legiferare contro le conseguenze involontarie dei proxy razziali?

Il termine AI è stato introdotto al Congresso dal Future of AI Act nel dicembre 2017, prima di allora non esisteva nulla come Governance AI. Sono quindi uno dei primi professionisti nel mio campo. La buona notizia è che tutti possiamo giocare un ruolo nel respingere i pregiudizi razzisti dell’AIAI è la battaglia per i diritti civili del nostro tempo; dobbiamo solo istruirci su come questi sistemi hanno un impatto sulla nostra vita quotidiana, quindi spostarci per servire i nostri migliori interessi. Un grande esempio di ciò sono gli abitanti di San Francisco che hanno vietato l’uso delle tecnologie di riconoscimento facciale negli spazi pubblici perché non volevano essere soggetti a costante sorveglianza governativa.