ORA L’IA PUÒ RICREARE IL MODO IN CUI GLI ARTISTI HANNO DIPINTO I LORO CAPOLAVORI

Di recente, i ricercatori del MIT hanno introdotto un nuovo sistema di intelligenza artificiale noto come Timecraft che ha la capacità di sintetizzare video time-lapse che descrivono come un determinato quadro potrebbe essere stato creato. Secondo i ricercatori, ci sono varie possibilità e combinazioni uniche di pennelli, pennellate, colori, ecc. In un dipinto e l’obiettivo alla base di questa ricerca è imparare a catturare questa ricca gamma di possibilità.

La creazione dello stesso pezzo esatto di un famoso dipinto può richiedere giorni anche a artisti esperti. Tuttavia, con l’avvento di AI e ML, abbiamo assistito alla nascita di un certo numero di artisti AI da alcuni anni. Uno dei più popolari artigiani dell’IA è il ritratto di Edmond Belamy che è stato creato da Generative Adversarial Network (GAN) e venduto per un incredibile valore di 432.500 dollari.

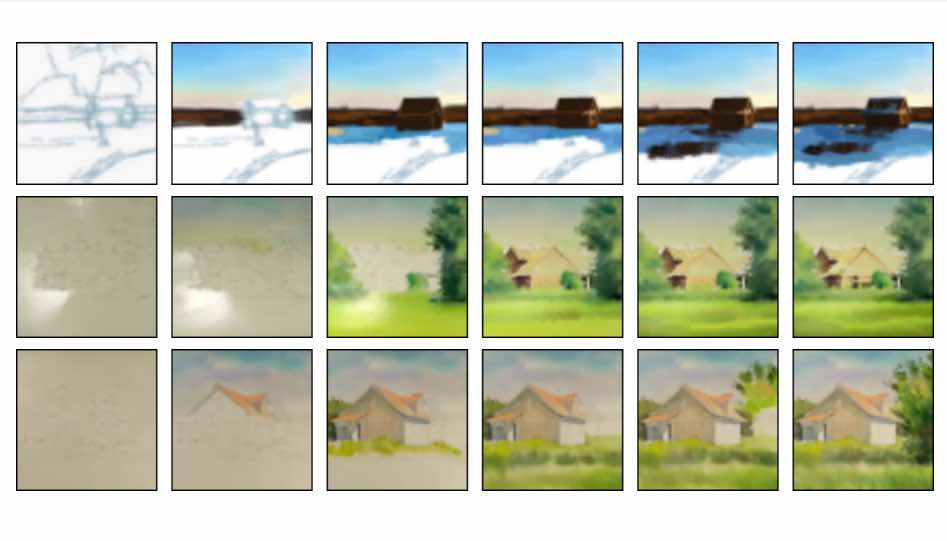

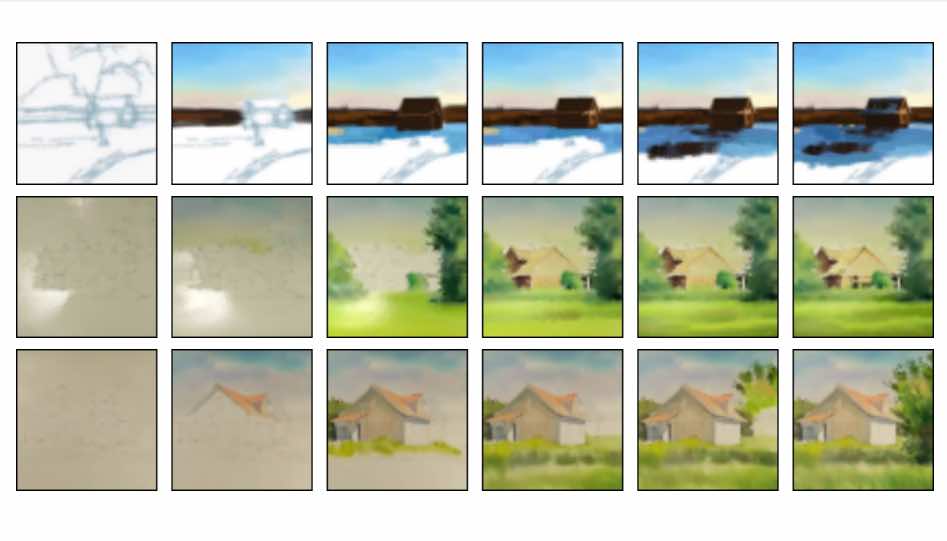

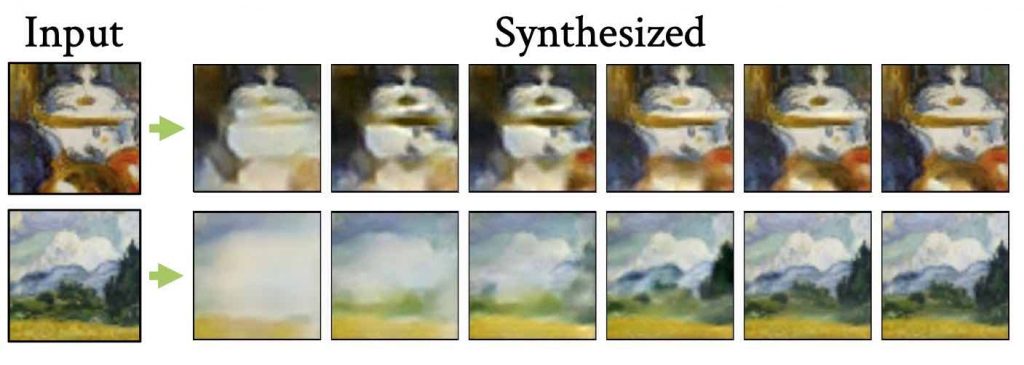

In questo studio, i ricercatori hanno presentato un modello probabilistico ricorrente che può catturare un’immagine di un dipinto finito e creare un video time-lapse raffigurante come probabilmente è stato dipinto dall’artista originale. Il sistema è stato formato su oltre 200 video time-lapse esistenti che le persone hanno pubblicato online sia su dipinti digitali che ad acquerelli.

Dietro il modello

Il modello è implementato come una rete neurale convoluzionale (CNN) e ha introdotto una politica di formazione per consentire l’apprendimento da un set di dati limitato e rumoroso di time-lapse di pittura. I ricercatori hanno lavorato con le registrazioni di time-lapse di pittura digitale e ad acquerello che vengono raccolte da siti Web di video. Il modello di rete neurale convoluzionale può guardare un nuovo dipinto che non è stato addestrato e capire il modo più probabile in cui è stato creato.

Nel processo, si sono imbattuti in una serie di sfide come le alte variabilità, tra cui traiettorie di verniciatura, disponibilità dei dati, tassi di verniciatura, ecc. E sfide di media specifica, tra cui effetti di cancellazione, effetti non pinta, ecc. Per superare questi problemi, i ricercatori hanno progettato un modello basato sull’apprendimento che ha la capacità di gestire le sfide.

Il modello di rete neurale viene implementato utilizzando un framework di autoencoder variazionale condizionale (CVAE) e i parametri del modello vengono appresi utilizzando brevi sequenze dal set di dati video di formazione. Utilizzando l’autoencoder sequenziale condizionale sequenziale (CVAE), il modello viene addestrato per ricostruire un frame reale mentre si basa sulle sue previsioni precedenti.

La formazione sequenziale CVAE ha aiutato a incoraggiare le sequenze di frame ad essere ben catturate dalla distribuzione appresa, riducendo la combinazione di errori. Per la sintesi video, i ricercatori hanno implementato il modello con l’aiuto delle famose librerie di machine learning , Keras e TensorFlow.

Set di dati utilizzato

Per addestrare il modello, i ricercatori hanno raccolto registrazioni time-lapse di dipinti da YouTube e Vimeo. Hanno affermato che i dipinti digitali e ad acquerelli venivano selezionati e si concentravano principalmente su paesaggi che di solito sono soggetti ben noti per entrambi i mezzi.

Ogni video è stato scaricato a una risoluzione di 360 × 640 e ritagliato temporalmente e spazialmente per includere solo il processo di verniciatura. I ricercatori hanno raccolto 117 intervalli di pittura digitale con una durata media di 4 minuti e 116 intervalli di acquerello, con una durata media di 20 minuti.

contributi

In questa ricerca, i contributi forniti dai ricercatori sono menzionati di seguito: –

I ricercatori hanno utilizzato un modello probabilistico per catturare le decisioni stocastiche prese dagli artisti, catturando così una distribuzione di modi plausibili per creare un dipinto.

A differenza del lavoro sulla futura previsione o interpolazione dei frame, i ricercatori hanno sintetizzato video a lungo termine che coprono decine di passaggi temporali e molti minuti in tempo reale.

Hanno dimostrato un modello che impara con successo dalla pittura che il tempo passa “dalla natura”. Secondo i ricercatori, qui i dati sono piccoli e rumorosi, poiché erano stati raccolti da ambienti non controllati con illuminazione variabile, risoluzione spaziale e velocità di acquisizione video.

Questo progetto può essere definito come il primo lavoro che modella e sintetizza le distribuzioni di video del passato, dato un singolo fotogramma finale.

Riassumendo

In questa ricerca, viene introdotto un nuovo metodo di sintesi video, che sta realizzando video time-lapse che raffigurano la creazione di dipinti. I ricercatori hanno proposto un modello probabilistico ricorrente che ha catturato le decisioni stocastiche degli artisti umani e ha introdotto uno schema di addestramento sequenziale alternato che incoraggia il modello a creare previsioni realistiche su più fasi temporali.

Secondo un post sul blog , i video di Timecraft hanno superato i benchmark esistenti oltre il 90% delle volte e sono stati effettivamente confusi per i video reali quasi la metà delle volte. Il modello può essere utilizzato per campionare molte fasi temporali, consentendo la sintesi video stocastica a lungo termine.

.