Questa patch colorata ti rende praticamente invisibile all’IA

La patch emette solo un algoritmo specifico, ma i ricercatori stanno lavorando su soluzioni più flessibili

L’aumento della sorveglianza basata sull’intelligenza artificiale è estremamente preoccupante. La capacità dei governi di rintracciare e identificare i cittadini in massa potrebbe significare la fine dell’anonimato pubblico . Ma come i ricercatori hanno dimostrato più e più volte, ci sono modi per ingannare tali sistemi.

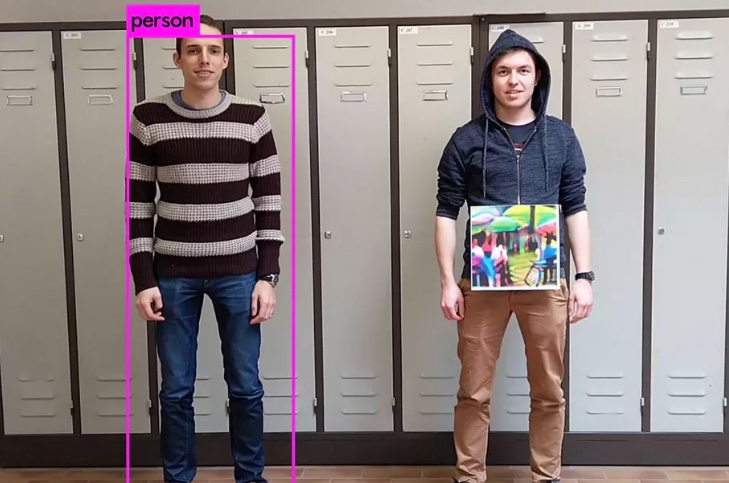

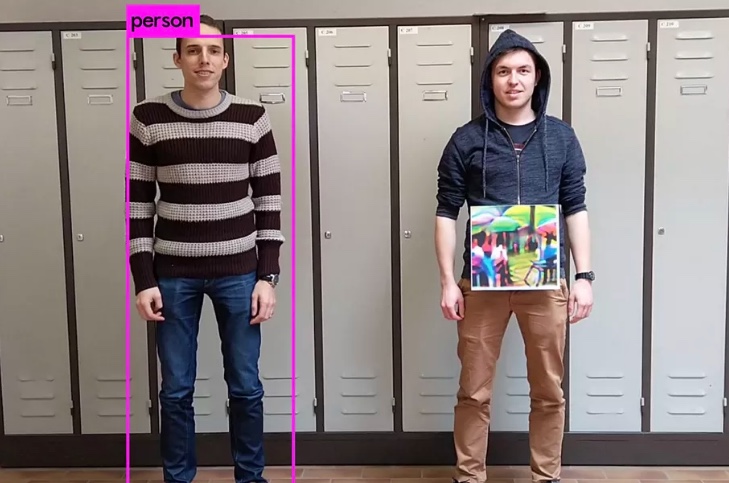

L’ultimo esempio proviene da un gruppo di ingegneri dell’università di KU Leuven in Belgio. In un documento condiviso la scorsa settimana sul server di preprint arXiv, questi studenti mostrano come semplici schemi stampati possono ingannare un sistema di intelligenza artificiale progettato per riconoscere le persone nelle immagini.

Se stampi uno dei taccuini appositamente progettati dagli studenti e lo appendi al collo, dal punto di vista dell’IA, puoi anche scivolare sotto un mantello dell’invisibilità.

Come scrivono i ricercatori: “Crediamo che, se combiniamo questa tecnica con una sofisticata simulazione di abbigliamento, possiamo progettare una stampa su una T-shirt che possa rendere una persona praticamente invisibile per le telecamere di sorveglianza automatiche.” (Non ne parlano, ma questo è, notoriamente, un importante dispositivo di trama nel romanzo di fantascienza Zero History di William Gibson.)

Questo può sembrare bizzarro, ma in realtà è un fenomeno ben noto nel mondo dell’IA. Questi tipi di modelli sono noti come esempi di contraddittorio e sfruttano la fragile intelligenza dei sistemi di visione artificiale per indurli a vedere ciò che non c’è.

In passato, per ingannare i sistemi di riconoscimento facciale sono stati usati esempi contraddittori. (Indossa solo un paio di occhiali speciali, e l’IA penserà che tu sia Milla Jovovich .) Sono stati trasformati in adesivi , stampati su oggetti 3D e persino usati per fare arte che può ingannare gli algoritmi .

Molti ricercatori hanno avvertito che gli esempi contraddittori hanno un potenziale pericoloso. Potrebbero essere usati per ingannare le auto che guidano da soli e leggere un segnale di stop come un lampione, ad esempio, oppure potrebbero ingannare i sistemi di visione artificiale dell’IA progettati per identificare le malattie . Questo potrebbe essere fatto a scopo di frode medica o anche intenzionalmente causare danni.

AI magica: queste sono le illusioni ottiche che ingannano, ingannano e fanno casino

Nel caso di questa recente ricerca – che abbiamo individuato tramite il ricercatore di Google David Ha – si applicano alcune avvertenze. Ancora più importante, la patch avversaria sviluppata dagli studenti non può che ingannare uno specifico algoritmo chiamato YOLOv2. Non funziona nemmeno con i sistemi di visione artificiale già pronti sviluppati da Google o da altre aziende tecnologiche e, ovviamente, non funziona se una persona guarda l’immagine.

Ciò significa che l’idea di una maglietta che ti rende invisibile a tutti i sistemi di sorveglianza rimane nel regno della fantascienza – almeno per il momento. Poiché la sorveglianza dell’IA è dispiegata in tutto il mondo, sempre più persone potrebbero desiderare un modo per riconquistare il nostro anonimato. Chissà: i turbini allucinogeni degli esempi contradditori potrebbero finire per essere la prossima grande tendenza della moda.